1. 들어가며

지난 8월 15일에 ML2의 이채혁님, 제영선님, 윤세현님이 AI Robotics KR 2025 세미나: Physical Intelligence for the Real World에 참석하였습니다.

이 세미나는 인공지능 로봇에 관심 있는 분들을 위한 비영리 커뮤니티인 AI Robotics KR에서 주최한 행사로, 매해 선발된 운영진 분들의 자원봉사로 운영되고 있습니다. 저희 ML2에서 인턴으로 근무하셨던 신수용님께서 올해 AI Robotics KR의 운영진으로 활동하셔서, ML2에서도 작게나마 후원과 함께 참여하게 되었습니다.

행사는 역삼역 부근의 정원 150명 규모를 가진 홀에서 진행되었는데, 티켓팅 하루만에 모든 티켓이 매진되고 당일 행사장도 빈 자리 없이 꽉 찼습니다. 많은 분들이 인공지능과 로보틱스에 열정이 있으시다는 것을 확인할 수 있었습니다.

150명 정원의 공간인데, 모든 자리가 가득 찰 정도로 많은 분들이 참여해주셨습니다.

저희 ML2에서는 경품을 후원했습니다. 젯슨 보드에 대한 반응이 좋은 커뮤니티입니다 ^^

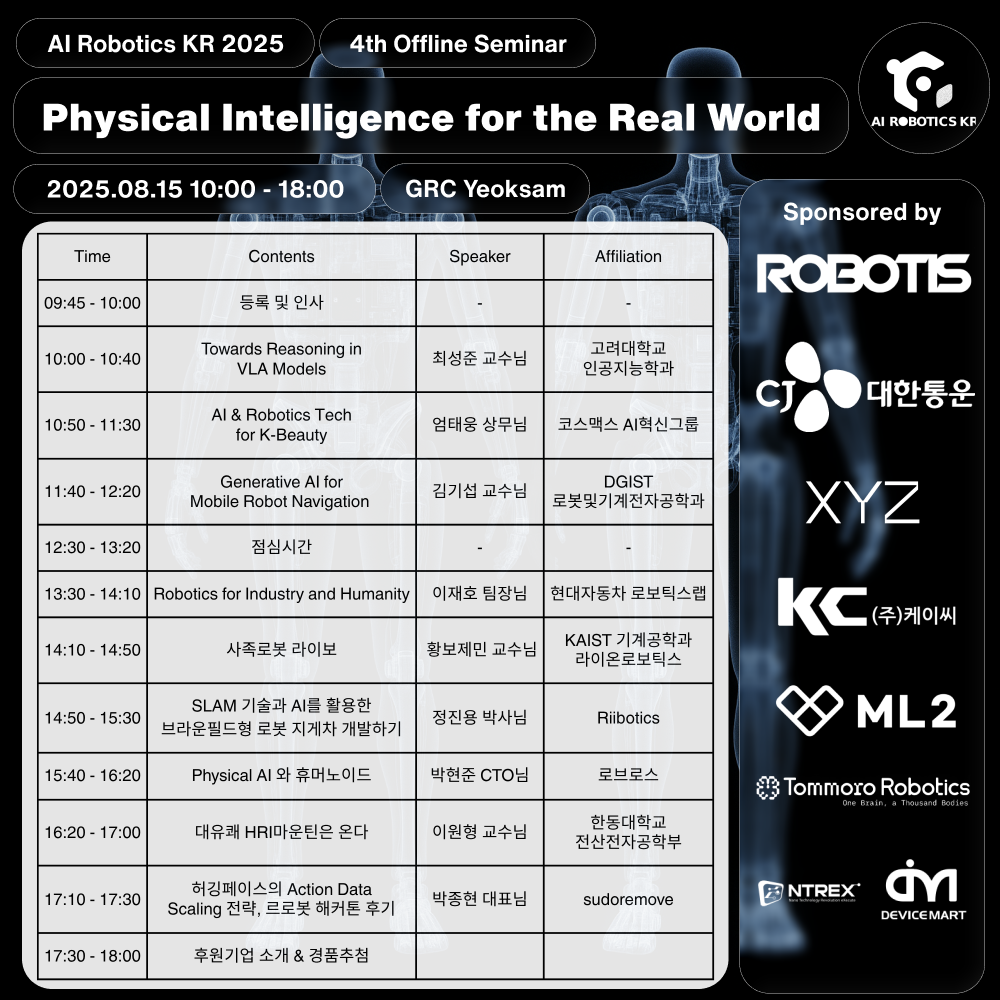

이번 세미나의 백미는 초호화 연사진 분들이었습니다. 아래 목록의 연사진 분들이 발표를 해주셨는데, 사실 이런 분들의 발표를 한 자리에서 들으려면, 등록비만 최소 100만원 정도 하는 국제 학회에 참석해야 합니다. 하루 만에 고수 분들의 깊은 통찰을 들을 수 있었던 귀중한 기회였고, 다시 한번 이러한 행사를 마련해주신 AI Robotics KR 운영진 분들과 연사 분들께 감사 드립니다.

저희 ML2에서는 로보틱스 중에서도 내비게이션 분야에 대한 연구 및 개발을 진행하고 있습니다. 그래서 본 포스트에서도 내비게이션 관련 발표를 해주신 DGIST 김기섭 교수님과 Riibotics 정진용 박사님의 발표를 중심으로 소개해드리고자 합니다.

❗현장 사진 촬영이 금지되었어서, 관련 자료는 김기섭 교수님 연구실 홈페이지와 Riibotics 홈페이지에서 가져오거나 저희가 별도로 작성하였습니다.

이번 세미나의 (화려한) 연사진

2. DGIST 김기섭 교수님

DGIST 김기섭 교수님은 “생성형 AI가 내비게이션을 어떻게 변화시킬 것인가” 를 주제로 발표해주셨습니다. 가장 최신 학술연구들을 소개해주셔서, 이 분야가 AI 도입과 함께 어떠한 방향으로 발전하고 있는지 엿볼 수 있는 기회였습니다.

현재 내비게이션 기술이 가진 크게 두가지 문제를 말씀해주셨는데, 첫번째는 globally consistent SLAM이 매우 고되다는 것이었습니다. 김기섭 교수님은 DGIST 이전에 네이버에서 사내 이동 로봇 개발에 참여하셨고, 여기서 로봇의 주행에 필요한 건물 전체의 지도를 SLAM으로 작성하였습니다. 문제는 이 정도 큰 규모의 지도의 작성은 매우 어렵다는 것입니다. SLAM 중 끊기는 부분이 많이 생겨서 전체 지도를 작성하는 것 자체가 어려웠고, 사람이 있는 환경인 만큼 변화가 자주 발생하는데 이 변화를 주기적으로 업데이트하고 지도를 유지보수하는데 매우 많은 노력과 시간이 필요했다고 합니다. 하지만 사람은 이러한 업데이트나 globally consistent map 없이도 건물 내에서 길을 찾아갈 수 있습니다.

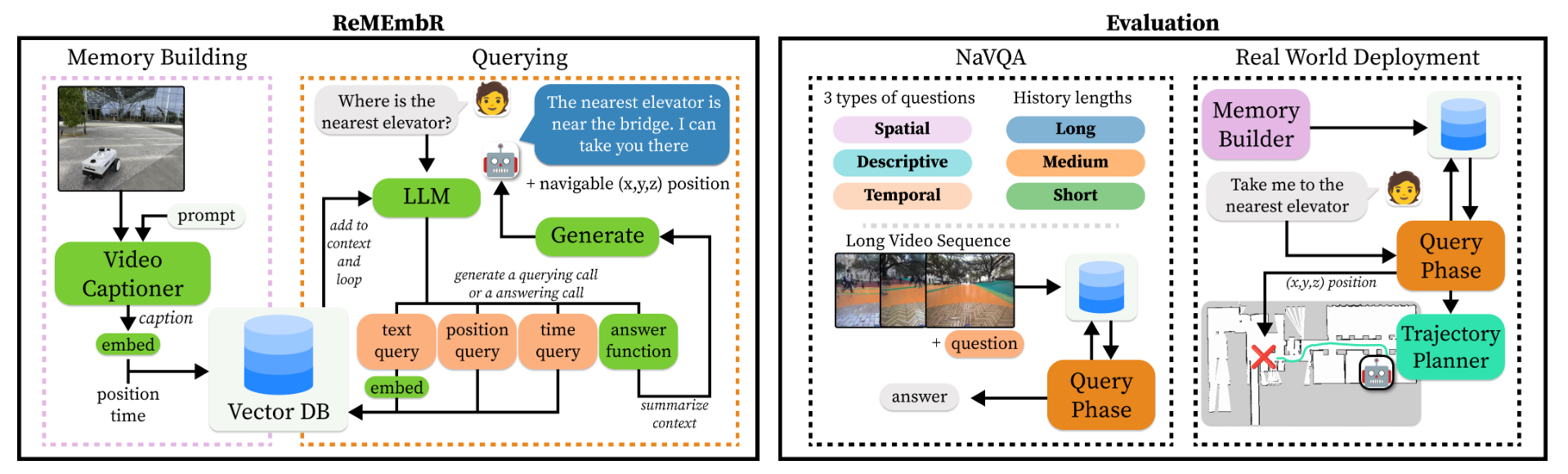

첫번째 문제의 솔루션은 지도의 type을 바꾸는 것입니다. 위에서 이야기한 globally consistent map은 3차원 공간에 배치된 3D point 기반의 지도입니다. 이 3D point로 이루어진 지도는 근본적인 한계가 있는데, 측정 오류나 부족한 최적화 연산으로 인해 다른 시점에서 관찰한 동일한 3D point들이 다른 위치를 갖게 되어 지도가 틀어지거나 끊어지는 문제가 발생합니다. 김기섭 교수님이 소개한 ReMEmbR [1] 라는 연구는 지도를 구성하는 데이터 자체를 이러한 3D point가 아니라, VLM의 embedding vector로 대체합니다. 사실 지도라기보다는 이미지에서 추출한 embedding vector를 저장한 memory database에 가깝습니다. 3D point 기반의 지도가 3D pose를 이용하여 목적지를 query하는데 반해, ReMEmbR에서는 언어를 이용하여 목적지나 현재 위치를 query합니다. 단순히 목적지를 지시하는 문장의 embedding vector과 가장 유사한 vector를 database에서 검색하는 것이기 때문에, 목적지 3D pose의 정확도와 내비게이션 결과와는 상관이 없습니다. 즉 globally consistent map이 필요없게 됩니다.

Architecture of ReMEmbR 1

두번째 문제는 전통적인 planning이 비정형 공간에서 동작하기 어렵다는 것이었습니다. 전통적인 planning은 공장과 같이 이동 가능한 영역이 정해져있는 같은 정형화된 공간에서는 잘 동작합니다. 하지만 이 로봇이 보행자 도로로 나가게 된다면, “사회적 규범”을 고려한 planning이 필요하다고 합니다. 가장 단순한 예로는 로봇이 인도로 다녀야한다는 것이 있겠고, 차도는 횡단보도로만 건너야 하고, 맨홀 구멍이나 수풀과 같은 장애물들은 피해가야 합니다. 기존의 planning 방법으로는 비정형 환경에서의 이러한 다양한 규칙을 모두 반영하기 힘들다고 합니다.

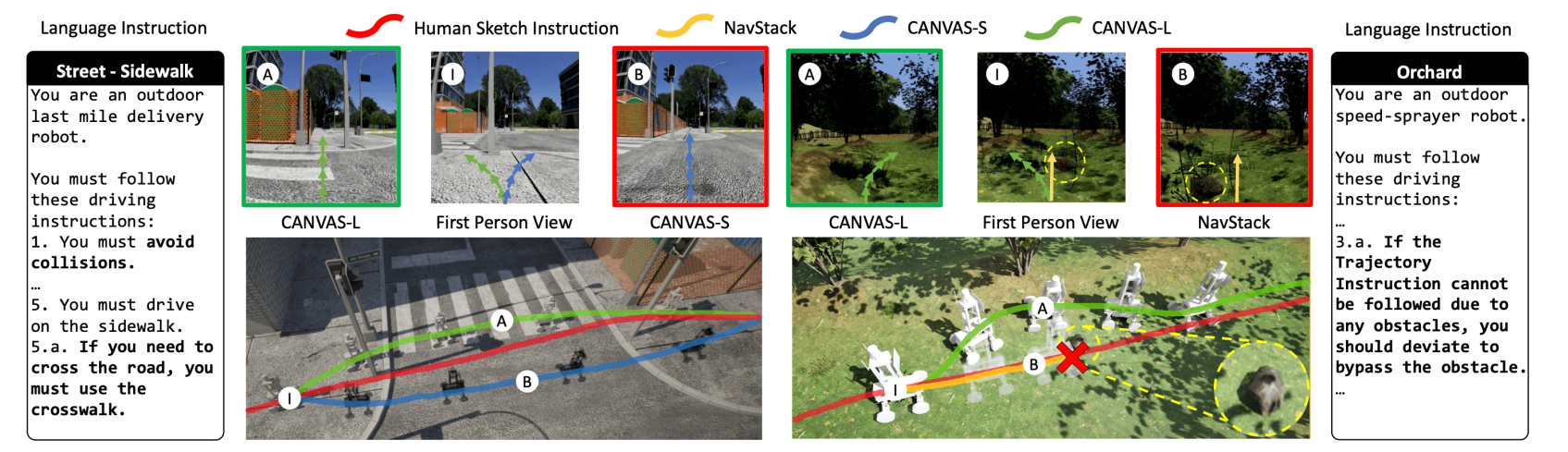

이 문제의 솔루션으로는 CANVAS [2] 연구가 소개되었습니다. CANVAS는 저희에게도 익숙한 연구인데, 저자 분들이 ML2에 방문해주셔서 해당 연구에 대해 발표하신 적도 있습니다. 이 연구에서는 다양한 기여를 제시하는데, 가장 중요한 포인트는 데이터 학습을 통해 path planning을 수행한다는 것이었습니다. 현재 상태를 입력으로 하여 다음 상태에서 적합한 위치를 LLM의 출력인 token으로 얻는데, 이 때 LLM은 image 데이터셋으로 fine-tuning되어 자동적으로 “규범”들을 학습하게 됩니다. 결과적으로 이 연구에서 로봇은 자동으로 횡단보도로만 건너고, 맨홀 구멍을 피해가며, 높은 수풀은 피하고 낮은 잔디는 그대로 지나가는 등 사람의 규범대로 path planning을 수행하는 모습을 보여줬습니다. 이를 논문에서는 “commonsense-aware navigation” 이라고 표현했습니다.

“사회적 규범”을 포함한 “commonsense-aware” path planning from CANVAS 2

물론 이러한 LLM이나 VLM을 활용한 내비게이션 방법들에도 한계는 있습니다. 하지만 지금까지 전통적인 navigation이 풀지 못했던 문제들이 해결되고 있다는 것은 분명하며, 앞으로 전통적인 방법과 생성형 AI를 조합한 더 나은 내비게이션 솔루션이 등장할 것이라는 말씀과 함께 강연을 마치셨습니다.

3. Riibotics 정진용 박사님

Riibotics의 CTO이신 정진용 박사님은 “SLAM 기술과 AI를 활용한 브라운필드형 로봇 지게차 개발하기” 라는 주제로 강연을 해주셨습니다. 앞선 다른 교수님들의 최신 학술 연구를 소개하는 발표와는 다르게, 현장의 문제들과 실제 기업에서 겪는 어려움을 들을 수 있어 재미있는 시간이었습니다.

자율주행 지게차 from Riibotics 블로그 3

개인적으로 브라운필드(brown-field) 라는 용어 자체를 이날 처음 들었는데, 이미 운영 중인 공장 (혹은 현장)을 뜻하는 단어라고 합니다. 보통 자동화 설비나 로봇이 공장에 배치될 때는, 공장 환경 자체를 로봇과 설비에 적합하게 세팅합니다 (green-field). 불필요한 턱을 없애서 로봇이 다닐 때 문제 없게 하거나, 로봇 경로에 사람이 다니지 못하게 펜스를 친다거나 하는 식입니다. 사실 이 방법이 로봇을 도입하기에 가장 효율적인 방법이긴 합니다. 그래서 보통 대기업에서는 공장을 처음부터 이런 컨셉을 갖고 짓습니다. 하지만 대부분의 자원이 부족한 중소-중견 기업에서는 공장을 새로 고칠 여력이 없습니다. 그래서 로봇을 도입하더라도 현재 공장 환경을 크게 바꾸지 않길 원하고, 이러한 시장을 브라운필드 시장이라고 한다고 합니다.

동적인 브라운필드 환경 @Riibotics 블로그 3

소개해주신 현장의 여러 문제들 중 “다양한 환경에 따른 인식 난이도” 문제가 흥미로웠습니다. (사실 ML2에서도 비슷한 문제를 풀고 있었기 때문에 ^^;)

일단 가장 문제가 되는 건, 매일매일 지도가 바뀐다는 겁니다. 작은 규모의 공장에서는 공간 활용의 효율성 때문에 용도 별로 구획을 명확하게 나눠놓지 않는 경우가 대부분입니다. 그렇기에 커다란 자재들이나 팔레트들을 그때그때 필요한 위치에 쌓아놓는 경우가 많습니다. 자재는 매일 들어오고 나가므로, 매일매일 환경이 바뀌게 되고, 큰 자재들이 많은 경우 지도 자체가 매일매일 바뀌게 됩니다. 이 경우 로봇이 localization에 실패하거나, 매일 지도를 새로 그려줘야 하는 문제가 발생합니다.

또한 지게차인만큼 팔레트를 정확히 인식하고, 어디에 지게팔을 넣어야 하는지 인식하는 것이 중요합니다. 그런데 현장에서 팔레트의 종류는 매우 다양하고 수시로 바뀝니다. 또 최종 출고되기 전 팔레트를 포함한 제품을 랩으로 둘러싸 포장하는 경우가 많은데, 사람은 팔레트 구멍이 랩으로 둘러싸여 있어도 그냥 비닐을 뚫고 지게팔이 들어가야할 위치에 로봇을 위치시키지만, 로봇은 라이다 등의 센서로 판단했을 때 그 비닐을 막혀있는 것으로 인식하기 때문에 뚫고 지나가는 결정을 하지 못합니다. 사람에게는 매우 쉬운 판단이 로봇에게는 매우 어려울 수 있다는 것을 다시 한번 느끼게 해준 실제 문제였습니다.

이 문제들에 대한 솔루션은 기업의 자산이기 때문에 자세한 설명은 해주시지 않으셨지만, 현장에서만 알 수 있는 이슈들을 공유해주신 것만으로도 큰 도움이 되었습니다. 특히 저희가 풀고 있는 문제들이 현장에서 보고 있는 문제와 비슷하다는 것을 알게 되어 마음이 놓이기도 했습니다. 저희가 의미 있는 문제를 풀고 있다는 확신이 중요하니까요.

4. 마치며

저명한 기술 리더들의 통찰을 한자리에서 압축해서 들을 수 있었던 정말 소중한 기회였습니다. 이러한 행사가 주기적으로 열리고, 또 자원봉사로 이루어진다는 점에서 한국의 다음 세대 로보틱스 연구자와 개발자들에 대한 기대가 커지는 시간이었습니다.

한편으로는, 이런 훌륭한 기술 리더 분들이 이끄는 그룹에서도 로봇의 사업화에서는 아직 명확한 답을 내리고 있지 못한다는 느낌을 받았습니다. 기술은 점점 발전하고 있지만 아직 사람들의 갖고 있는 “로봇”에 대한 눈높이는 충족하지 못하고 있습니다. 이는 한국 뿐만 아니라 전세계 로보틱스 커뮤니티의 숙제이기도 합니다.

❗위의 내용은 발표에서 들은 기억을 바탕으로 글쓴이가 옮겨 적은 것으로, 강연을 이해하고 정리하는 과정에서 실제 내용과 다른 부분이 있을 수 있습니다. 혹시 발견되는 오류들은 모두 글쓴이가 잘못 옮긴 내용입니다 ^^

5. 참고문헌

[1]

Anwar, Abrar & Welsh, John & Biswas, Joydeep & Pouya, Soha & Chang, Yan. ReMEmbR: Building and Reasoning Over Long-Horizon Spatio-Temporal Memory for Robot Navigation. arXiv preprint. 2024.

[2]

Choi, Suhwan and Cho, Yongjun and Kim, Minchan and Jung, Jaeyoon and Joe, Myunchul and Park, Yubeen and Kim, Minseo and Kim, Sungwoong and Lee, Sungjae and Park, Hwiseong and others, CANVAS: Commonsense-Aware Navigation System for Intuitive Human-Robot Interaction. arXiv preprint. 2024.

[3]

Seungmin Baek (2025, August 31). Defining 'Brownfield Robotics’. Riibotics Blog. https://view.riibotics.io/blog/riibotics-blog/defining-brownfield-robotics